Ketika strain H2009N1 influenza yang baru ditemukan di 1, prosedur pemantauan dan observasi yang biasa diaktifkan di AS, yang mencakup pelaporan semua kasus oleh pusat kontrol dan pencegahan kesehatan regional.

Prosedur yang luas dan teruji, yang memiliki batasan: itu menguraikan gambaran perkembangan virus, selalu dua minggu di belakang situasi kontingen.

Pada periode yang sama, majalah Alam menerbitkan sebuah artikel di mana beberapa insinyur Google, di tengah keheranan dan ketidakpercayaan, mengklaim dapat memperoleh dan bahkan memprediksi penyebaran geografis H1N1 hanya berdasarkan kata kunci yang digunakan di web.

Secara khusus, mulai dari 50 jutaan kata yang sebagian besar digunakan di web oleh pengguna AS, guru Mountain View telah mengidentifikasi yang paling banyak digunakan di daerah yang dilaporkan oleh pusat kesehatan regional, dan menerapkan 450 jutaan model matematika yang berbeda telah berhasil menyoroti korelasi antara 45 kata kunci dan perluasan virus.

Fakta-fakta mengkonfirmasi berita tersebut, dan untuk pertama kalinya ditunjukkan bahwa adalah mungkin untuk memprediksi penyebaran virus menggunakan metode matematika murni, yang pada dasarnya menggunakan sejumlah besar data yang diproses oleh mesin dengan kemampuan komputasi yang memadai.

Kisah ini adalah bukti lebih lanjut tentang bagaimana revolusi digital didirikan Teknologi Informasi (IT), telah merevolusi zaman kita. Dari sinilah mulailah apa yang disebut sebagai "revolusi industri keempat", suatu perubahan besar yang berkembang dengan luas dan kecepatan yang tidak pernah terlihat sebelumnya, menginvestasikan sejumlah bidang seperti yang belum pernah terjadi sebelumnya.

Inteligensi Buatan (IA), robotika, bioteknologi, teknologi nano, Internet of things (IoT), panduan otonom, komputasi kuantum hanyalah beberapa sektor yang mengalami periode kemajuan berkelanjutan, luar biasa untuk variasi dan kedalaman hasil dan untuk kecepatan pengembangan.

Dari akronim IT, seringkali, kita fokus pada teknologi T, yaitu komputer: semakin banyak mesin yang kuat, mampu menggandakan kapasitas komputasi setiap 18 bulan, menurut sebuah undang-undang - dikatakan oleh Moore1 - yang, meskipun kurang memiliki nilai ilmiah, tetap didukung oleh pengamatan realitas 50 yang lebih lama.

Yang mengatakan, dan mengambil apa pun dari pentingnya berasal dari mesin yang semakin kuat, kekayaan nyata hari ini terletak pada data, atau lebih tepatnya pada DATA BESAR yang diperoleh dari miliaran informasi yang dihasilkan setiap instan dengan klik, tweet, dan preferensi pembelian kami.

Pada kuartal pertama 2018, Facebook memiliki 2.19 miliaran pengguna aktif2, yang pada gilirannya berinteraksi dengan 200 milyaran individu lain dalam jaringan: angka di luar 20% dari populasi planet ini. Pada tahun yang sama, YouTube berdiri di satu setengah miliar pengguna, diikuti oleh WhatsApp dengan satu miliar tiga ratus juta.

Nomor-nomor penting, yang menghasilkan sumber data yang tidak ada habisnya.

Sebaliknya, web itu adalah lingkungan di mana jutaan orang setiap hari menghabiskan bagian penting dari kehidupan mereka (di Italia, rata-rata 6 jam sehari di 2018), bertukar pendapat, emosi, kesenangan, kesedihan, preferensi pembelian dan masih banyak lagi.

Seperangkat perilaku individu yang dapat "tanggal", yaitu direkam, dianalisis dan ditata ulang sesuai dengan kriteria ilmiah yang terus menerus menghasilkan data.

Dua contoh, terutama, memberikan gambaran bagaimana hasil yang kita cari tersembunyi di dalam informasi.

Dalam 2006, portal AoL (Americaonline) telah mempublikasikan, bagi para sarjana dan peneliti, sebuah database 20 dari jutaan "permintaan" yang dilakukan selama tiga bulan oleh pengguna 675mila, dan telah melakukannya dengan sebelumnya membuat anonimitas, untuk alasan perlindungan. , pengguna dalam berbagai kapasitas yang terlibat. Namun demikian, setelah beberapa hari, seorang janda berusia enam puluh tahun dari Georgia, Thelma Arnold, - benar - terkait dengan nomor pengguna 4417749, memicu perselisihan yang menyebabkan pemecatan tiga karyawan AoL.

Dan bahkan ketika Netflix menerbitkan preferensi sekitar setengah juta pengguna anonim, tidak lama kemudian seorang wanita Midwestern dikenali dengan nama dan alamat. Para peneliti di University of Texas telah menunjukkan bagaimana sebenarnya memungkinkan untuk mengenali pengguna saluran dengan memilih hanya film 6 di 500.

Tapi ini bukan hanya tentang web: mari kita pikirkan tentang kamera, di mana-mana di jalan-jalan dan alun-alun kota kita, dan tentang cara dan tujuan jejak yang kita tinggalkan dapat digunakan oleh perangkat lunak pengenal wajah khusus (beberapa tahun yang lalu, sebuah surat kabar Inggris) menemukan bahwa kurang dari 200 meter dari rumah tempat George Orwell, penulis buku dystopian "1984" tinggal, tidak kurang dari kamera 30).

Menurut Viktor Schonberger dan Keneth Cukier dalam pekerjaan fundamental mereka3 (digunakan sebagai sumber utama untuk artikel ini), begitu banyak data diproduksi di 2012 bahwa jika dimuat ke CD-ROM akan membentuk lima tumpukan paralel yang dapat mencapai bulan, sedangkan jika mereka dicetak pada lembaran kertas, mereka akan mampu untuk menutupi seluruh wilayah AS tiga kali.

Perhatikan bahwa kita berbicara tentang 6 tahun yang lalu, dan sementara itu data yang diproduksi setiap tahun dua kali lipat dua kali lipat (rata-rata, dua kali lipat setiap tiga tahun).

Data tersebut merupakan emas hitam pada zaman kita: nilai yang tak ternilai, karena kuantitas dan banyaknya penggunaan, paling sering berbeda dari yang digunakan pada awalnya. Bahkan, semakin sering, kami memberikan informasi di internet untuk tujuan yang tidak diketahui pada saat pengumpulannya.

Data tersebut merupakan emas hitam pada zaman kita: nilai yang tak ternilai, karena kuantitas dan banyaknya penggunaan, paling sering berbeda dari yang digunakan pada awalnya. Bahkan, semakin sering, kami memberikan informasi di internet untuk tujuan yang tidak diketahui pada saat pengumpulannya.

Mereka memberi makan perbatasan baru AI, yang merupakan bahan bakar pertama: itu berkat mereka, bahwa komputer maju dan mulai "merasakan" realitas eksternal.

Melalui robot mereka mulai melakukan tindakan otonom4, diputuskan berdasarkan data situasi yang dikumpulkan dan dianalisis secara eksternal (dan bukan dari pemrograman yang diterima).

Tetapi bagaimana DATA BESAR digunakan? Menerapkan metode matematika, "algoritma", diuraikan berdasarkan apa yang ingin ditemukan pada saat tertentu, dari fenomena tertentu.

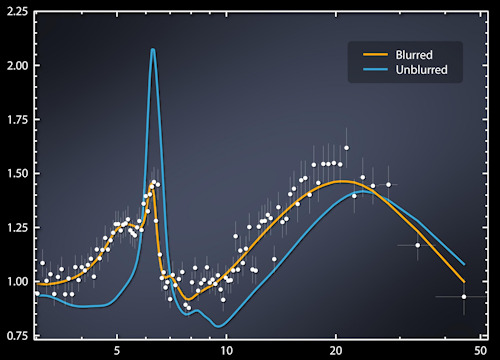

Algoritma, yang mengeksploitasi data dalam jumlah besar, memungkinkan kita untuk melihat kemungkinan "korelasi", dipahami sebagai probabilitas bahwa hubungan tertentu antara elemen-elemen yang diteliti dapat diulang.

Bahwa ikatan ini muncul secara kebetulan murni tidak mengurangi validitas penelitian itu sendiri, karena ketidaktepatan dan ketidaktepatan secara statistik "disesuaikan" sebanding dengan jumlah data yang tersedia.

Dengan segala hormat pada prinsip kausalitas, yang baik-baik saja di era DATA KECIL ketika pemahaman didasarkan pada analisis yang cermat dari elemen (terbatas) yang tersedia, yang dilakukan oleh orang "ahli" di sektor tertentu yang diteliti.

Di era DATA BESAR, pemahaman fenomena datang sebagai gantinya dengan bantuan "ilmuwan data" - persilangan antara seorang programmer, seorang ahli matematika dan seorang ahli statistik - dan bukan ahli tradisional.

Memang, dalam big data terletak kebenaran: tidak mengherankan, algoritma yang menawarkan hasil yang tidak memuaskan (probabilistik) dengan jumlah data yang terbatas bekerja untuk bertanya-tanya ketika diterapkan pada jumlah yang lebih besar.

"Google Translator" memberikan contoh yang jelas tentang bagaimana kriteria probabilistik yang dikombinasikan dengan jumlah informasi dapat diterapkan untuk menyelesaikan masalah yang kompleks seperti terjemahan.

Sebenarnya, program ini tidak menerjemahkan dengan menerapkan aturan tata bahasa atau menggunakan kamus yang tersimpan, tetapi berdasarkan probabilitas bahwa isi dokumen yang diberikan dapat diterjemahkan sesuai dengan struktur tata bahasa dan makna kata, kata kerja dan kata sifat yang ada dalam miliaran dokumen, dalam semua bahasa yang ada dalam ingatannya.

Dengan cara ini, program ini memenangkan persaingan dengan Microsoft dan dengan cepat menjadi penerjemah yang paling banyak digunakan di dunia.

Dalam konteks seperti itu, sebagaimana telah disebutkan, kapasitas komputasi hanya mewakili sebagian dari proses, bahkan tidak yang paling penting, serta algoritma yang digunakan dari waktu ke waktu. Faktor penentu tetap jumlah data yang tersedia: semakin banyak yang kita miliki, semakin besar kemungkinan kita untuk menemukan apa yang kita cari.

DATA BESAR "menempatkan sayap mereka" pada revolusi industri keempat, dan memungkinkan pemahaman yang lebih besar tentang dunia. Belajar untuk mengelolanya dan menggunakannya sepenuhnya adalah tantangan yang menanti kita.

3DATA BESAR oleh Viktor Schonberger dan Keneth Cukier - Garzanti 2013

4Suatu sistem disebut "terotomatisasi" ketika ia bertindak terutama dengan cara deterministik, selalu bereaksi dengan cara yang sama ketika mengalami input yang sama. Sebaliknya, sistem "otonom" beralasan berdasarkan probabilitas: setelah menerima serangkaian input, ia memproses jawaban terbaik. Tidak seperti apa yang terjadi dengan sistem otomatis, sistem otonom, dengan input yang sama, dapat menghasilkan jawaban yang berbeda.

Foto: Emilio Labrador / NASA